Las especialidades médicas, entre ellas la nefrología, evolucionan a través de un proceso de revisión y análisis de los estudios de investigación que solo se consigue al exponerlos, compararlos y someterlos a una revisión por pares. Esto implica —entre otras cosas— recurrir a la búsqueda, la lectura y la selección de artículos relevantes en un número siempre mayor de publicaciones. Esta tarea suele ser muy compleja y laboriosa.

Por otro lado, los estudios de investigación pueden afectar a la práctica médica solo si son leídos o revisados por otros profesionales. De los casi 2 millones de manuscritos publicados anualmente, hasta el 50% son leídos solo por los autores, el editor de la revista y los revisores, y la mayoría nunca son citados1.

Junto con estos desafíos, el enorme desarrollo de los distintos medios digitales nos permite buscar un artículo, guardarlo, discutirlo, compartirlo o citarlo2.

Las herramientas utilizadas clásicamente para evaluar el impacto de un artículo se basan principalmente en las citaciones de un artículo y no son capaces de medir su importancia en el nuevo escenario digital, donde la interconexión y la expansión de los recursos por una educación médica gratuita y de acceso libre, más conocida en su sigla anglosajona FOAMED (Free Open Access Medical Education), han permitido el surgimiento de nuevas métricas de artículos, apostrofadas erróneamente, como métricas alternativas (MA) o Altmetrics3.

La difusión de contenido científico en redes sociales aumentaría y definiría mejor el impacto de los trabajos en la comunidad científica4. Recientemente, un estudio retrospectivo expuso que una estrategia activa de promoción en Twitter incrementa en 11veces la probabilidad de ser citados (75% vs. 7%); además los artículos tuiteados fueron citados con anterioridad1. Por otro lado, estudios aleatorizados más antiguos no pudieron confirmar esta asociación, intuyendo que era posible que los usuarios de las redes sociales no hayan tenido la necesidad de acceder al artículo completo y, por lo tanto, hayan experimentado mayor conocimiento del artículo, pero no acceso en línea a la fuente principal5.

Hasta hace poco, la calidad y la relevancia de un artículo científico publicado se medía mediante la aplicación de sistemas de medición (métricas) tradicionales que contabilizan el número de citas o visualizaciones. El resultado de este análisis se aplicaba para evaluar la capacidad investigadora de un autor (p. ej., índice H) o la relevancia de una revista científica, siendo el factor de impacto (acrónimo anglosajón, IF) uno de los más utilizados. Estos índices suelen ser subrogados (métodos de sustitución o sustitutos) para evaluar la calidad del trabajo analizado y no dejan de generar cierta polémica en su valoración6. En ambos casos el valor de estas métricas es limitado debido a que dependen de un recuento de citas de publicaciones posteriores7. Este es un proceso lento, que puede llevar meses e incluso años, resultando en una larga espera para los investigadores antes de que los lectores descubran la importancia o relevancia de un artículo o ensayo clínico.

Además, las citas que recibe un artículo no siempre son un reflejo de la calidad de este, ya que existen artículos que han sido en gran medida citados como resultado de un proceso de refutación más que por su calidad; esta limitación aplica también a las nuevas métricas.

Por otra parte, en la última década, hemos observado un aumento vertiginoso de las publicaciones biomédicas que han puesto a prueba los clásicos sistemas existentes para evaluar y seleccionar los trabajos científicos, como la revisión por pares. No obstante, una vez publicado, puede llevar meses o incluso años para que se descubra la importancia o relevancia de un artículo o ensayo clínico.

La difusión imparable de las redes sociales y el aumento del número de artículos de acceso libre (Open Access Journals) han hecho que la lectura y la discusión de los trabajos científicos se haya extendido más allá de los estrechos círculos académicos difundiéndose entre la opinión pública8. Las redes sociales están suponiendo una alternativa para una mayor forma de difusión, intercambio y discusión de artículos científicos. Estos cambios tan sustanciales han obligado a buscar fuentes de datos alternativas y complementarias a las métricas tradicionales (MT), como se definió en el Altmetrics: A manifesto, del 20109. En este sentido, se ha propuesto el término de métricas de artículos (Article-Level Metrics, acrónimo anglosajón ALMs), como una herramienta para poder evaluar de una forma diferente el impacto de un estudio científico10.

Debido a su rápida difusión, es fácil observar cómo Altmetrics o las MA son términos utilizados para referirse, de forma errónea, a las métricas reales de artículos.

Las MA miden el impacto que tiene un artículo individual en varios dominios según los índices de actividad, en tiempo real11,12. Recopilan datos públicos mediante códigos fuentes y algoritmos artificiales de distintas plataformas y pagina web (blog, journal club) que se caracterizan por permitir el acceso al artículo (Pubmed, Figshare), guardarlo (Mendeley, CiteUlike), discutirlo y compartirlo (Twitter, Facebook), recomendarlo (Faculty Opinions) o citarlo (Crossref, Scopus).

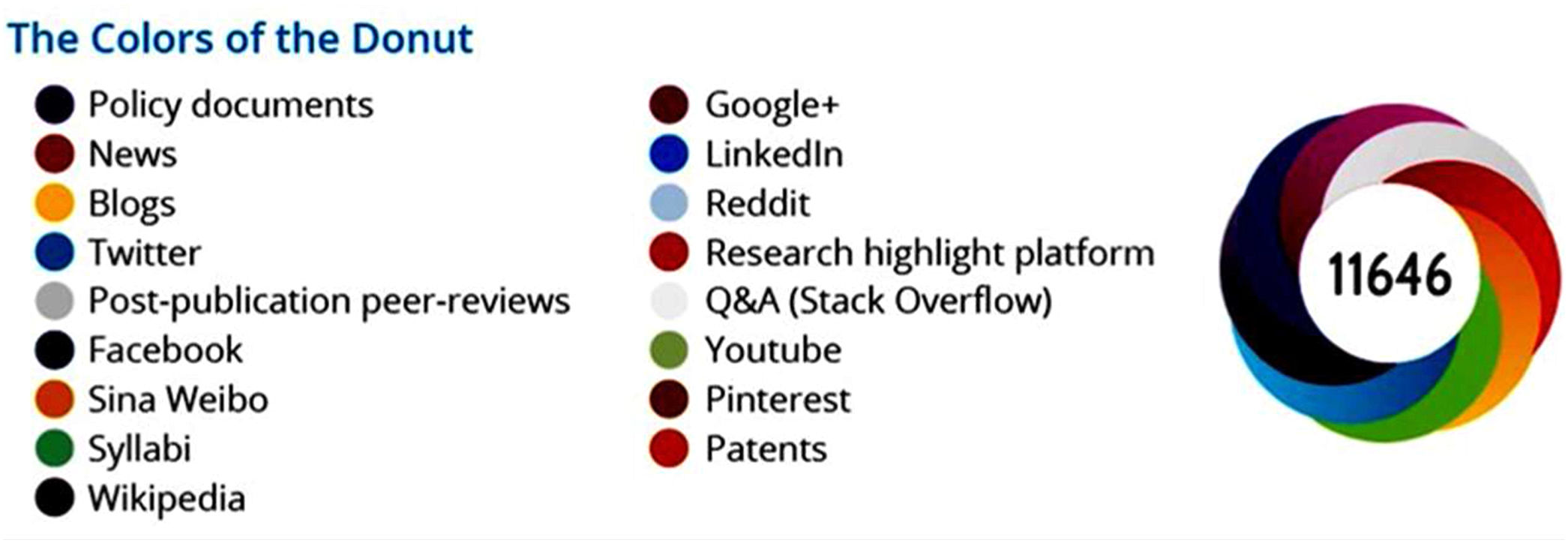

Los números de visualizaciones, citaciones, likes, retweets permiten calcular tanto el impacto académico o social del artículo, así como la composición detallada del impacto y finalmente medir la actividad investigadora de un autor13,14 (fig. 1).

Donut Altmetrics: ejemplo de métricas de artículos que contabiliza el número de citaciones y visualizaciones («métrica tradicional»), así con el número de condivisiones vía redes sociales o blog. El tamaño de los colores del donut cambiará de forma proporcional a las interacciones recibidas por cada fuente.

Fuente: https://www.altmetric.com/about-our-data/the-donut-and-score/.

Hay varias compañías que han desarrollado programas y ofrecen sus servicios a las distintas revistas científicas, entre las más importantes se encuentran Altmetrics.com, Plum Analytics, Impact Story, entre otras. Estas son herramientas de conteo que buscan en Internet datos para evaluar el impacto social de la investigación académica. Se presentan mediante diseños visuales muy inteligentes adjuntos a los artículos o publicaciones científicas y brindan retroalimentación inmediata que permite al lector interesado ver las fuentes que acceden al artículo muy rápidamente. Se debe destacar que Altmetrics.com ha basado su negocio principalmente en el suministro de métricas e indicadores a editores académicos. Asimismo, PlumX ha encontrado en las instituciones la forma de desarrollar su actividad, ofreciendo un «tablero» para rastrear su impacto social. Esta práctica comercial ha insertado sus puntaciones en el entorno editorial académico mucho antes de haber sido probados como indicadores de investigación confiables y significativos, causando una mala interpretación considerable sobre sus significado e importancia.

Otra oportunidad que nos ofrecen el análisis de artículos mediante las métricas de alternativas son algunas plataformas como Semantic Scholar (Semantic Scholar|About Us)15. Se trata de un buscador de contenidos académicos gratuitos que utiliza el aprendizaje automático o inteligencia artificial para analizar publicaciones, incluyendo figuras, tablas, asociaciones semánticas y la métrica de artículos científicos para ordenar los resultados que un algoritmo considere más relevantes.

Una posterior aplicación es la posibilidad de analizar cuáles son los campos de interés de la opinión pública o de determinados colectivos científicos y poder orientar las líneas editoriales para responder a esta demanda.

Estas herramientas novedosas han sido adoptadas cada vez más por instituciones que desean ayudar a sus investigadores a fortalecer las solicitudes de financiación y encontrar historias interesantes que contar sobre su trabajo.

La mayoría de los financiadores, sean públicos o privados, otorgan fondos en función de la calidad de una idea y el historial de un solicitante, de los cuales el currículo académico suele ser una parte importante. Las MA pueden ayudar a los comités evaluadores a analizar el alcance y la influencia del trabajo académico, candidato a la financiación, tendría tanto dentro como fuera de la esfera académica, quizás reduciendo cualquier dependencia de las suposiciones de que la investigación publicada en revistas más «prestigiosas» tiene necesariamente un mayor impacto16.

¿Es correcto beneficiar a un investigador que publique muchos artículos poco originales sobre el mismo tema, pero en revistas internacionales, o es mejor beneficiar a aquel con pocos artículos —pero originales—, curiosos, con perspectivas novedosas publicados en revistas regionales?17.

Las MA pueden ser particularmente beneficiosas para los investigadores emergentes, especialmente aquellos que pueden no haber tenido la oportunidad de acumular un número de publicaciones suficientes para ser competitivos en indicadores tradicionales, o aquellos investigadores cuyos campos de interés limiten su capacidad de publicar en revista de alto impacto16.

Los mismos financiadores y organizaciones corporativas podrían consultar los resultados de sus programas y modular sobre estos sus estrategias de investigación18.

Finalmente, estas herramientas podrían ayudar a los investigadores no solo a rastrear los resultados de su investigación, sino también a planificarla por adelantado y promoverla activamente en busca de fuentes de financiación para lograr el impacto que pueda tener.

Con este fin, el autor debería desarrollar sus propias estrategias para promover y difundir su trabajo lo más ampliamente posible, valorando, en el momento de elegir en qué revista publicar, si cuenta con un programa de MA o si está vinculada a las principales plataformas de medios sociales. En relación con esto, el investigador se debería hacer algunas de las siguientes preguntas: ¿tiene la revista presencia en Twitter o Facebook, o un blog?, ¿tiene alguna otra presencia en medios de divulgación de acceso libre o redes sociales, como LinkedIn, Wikipedia, YouTube?19.

Dar a conocer el propio trabajo es de vital importancia para poder conseguir fondos de investigación, ¿habría podido ser diferente la historia del Prof. Mojica, descubridor de la técnica CRISP-Cas9 e ignorado durante años por el sistema de financiación pública si hubiera sabido comunicar su descubrimiento a nivel social?20.

Una de las principales dudas sobre estas nuevas herramientas es la existencia de una correlación entre artículos altamente citados y su puntuación mediante MA.

La evidencia de revisiones sistemáticas sobre este tema parece ser escasa. De hecho, hasta la fecha solo hay 3: la primera se concentró en el resultado de la investigación médica e informó de asociaciones significativas entre Altmetrics y citas tradicionales, sin vincular las medidas de impacto21; la segunda tuvo como objetivo la evaluación de la calidad metodológica en psoriasis cutánea determinando que el IF de una revista podía predecir la cantidad de tweets, mientras que los años de publicación y la cantidad de lectores de Mendeley pronostican la cantidad de citas en Google Scholar7. Sin embargo, los autores concluyeron que no parece haber una conexión entre la calidad científica, las redes sociales, la actividad y el uso del artículo22.

En una revisión sistemática más reciente, en la que se analizó la asociación entre las puntaciones Altmetric y la bibliometría, los resultados fueron mixtos. No se informaron correlaciones significativas en 12 de 44 estudios (27%), habiendo correlaciones débiles o moderadas en el 30% y asociaciones positivas en el restante 43%. En particular, hubo una asociación positiva entre los lectores de Mendeley (lecturas y descargas) y las citas posteriores23.

Estos datos son similares a los hallazgos reportados en uno de los estudios de impacto, que encontró correlaciones significativas entre el número de descargas de un artículo y el número posterior de citas (r=0,52; p<0,001), que fueron aún mayores en el grupo de intervención (r=0,67; p<0,001)24.

No obstante, en otros 2 estudios no se evidenciaron asociaciones significativas entre las MT y de redes sociales25 y entre la puntuación Altmetric, el IF de la revista, las lecturas de ResearchGate, un repositorio de artículos científicos, y la cantidad de descargas de artículos26.

A pesar de que en la literatura se encuentran estudios con resultados discordantes, es de esperar que una mejoría en la correlación de estos algoritmos sea solo cuestión de tiempo27,28.

Las comparaciones entre MC y MA son sujeto de discusión, ya que a menudo es difícil evaluar la credibilidad de los críticos y la validez de sus comentarios. Aunque las MA intentan abordar estas limitaciones al examinar y ponderar las contribuciones de los autores en cada mención; obviamente, el grado de difusión en redes sociales no reemplaza la capacidad crítica de los lectores29.

Otra limitación en el uso de las MA para los artículos científicos es la falta de transparencia sobre los códigos fuente y los API (interfaz de programación de aplicaciones: un código que permite que 2programas de software se comuniquen entre sí), utilizados para rastrear las citaciones en las distintas fuentes. Además, es difícil crear un sistema de algoritmos y código fuente replicable porque la velocidad con la cual evolucionan las plataformas web es asombrosa.

Las fuentes de las que se toman los datos de un artículo científico son muy heterogéneas y difícilmente comparables (p. ej., ¿es lo mismo un «me gusta» en Facebook que una citación en un blog?). Finalmente, las MA son susceptibles de ser manipuladas: una buena campaña de marketing puede aumentar el impacto de una publicación recurriendo incluso a técnicas Search Engine Optimization (SEO), posicionamiento en buscadores30.

Para intentar solventar estos problemas se han desarrollado una serie de iniciativas como el informe «Metric Tide» en el Reino Unido, el «Metrics Toolkit» y el «Grupo de expertos en indicadores», creado por la Comisión Europea con el fin de proporcionar información basada en evidencia sobre cómo se calcula cada métrica, dónde y cómo debería (y no debería) aplicarse31-33.

El aumento exponencial de publicaciones científicas y la multiplicación de herramientas que permiten difundir sus contenidos genera incertidumbre acerca de la medición del verdadero impacto científico de los manuscritos ya que está basado en sistemas tradicionales y que presentan ciertas limitaciones en el contexto actual. Las métricas de artículos basadas sobre presencia y prevalencia en un contexto digital y social pueden complementar a los indicadores bibliométricos «tradicionales» (bien establecidos, conocidos y aceptados por la mayor parte de investigadores) y han llegado para quedarse. No obstante, y pese a sus imperfecciones, como en muchos otros campos revolucionados por las nuevas tecnologías, ofrecerán oportunidades a quien esté dispuesto a asumir el nuevo reto y nos permitirán orientarnos para comprender mejor lo que nuestros colegas y pacientes están leyendo y escuchando. Además, el análisis del verdadero impacto científico y social de un tema de investigación ayudaría a establecer estrategias adecuadas para responder óptimamente a las necesidades de la sociedad.